Brukere som blir oppfordret til å installere den neste versjonen av Apples mobile operativsystem vil ha muligheten til det slett lydopptakshistorien Siri fra serverne.

Fair er rettferdig, og det er like rettferdig at Apple har en sjanse til å forbedre Siri-brukeropplevelsen ved å samle inn data som det er bare at brukerne har en sjanse til å bestemme seg for om de vil dele opptakene sine eller ikke.

Men før du fortsetter med temaet som angår oss i dag, er det verdt å nevne at Siri-opptakene som Apple-butikker er lydkommandoer som er kryptert for å beskytte brukernes personvern. Disse opptakene er ment å vurdere kvaliteten på den virtuelle assistenten, samt forbedre Siris nøyaktighet og pålitelighet.

Det kan interessere deg | 6 triks for å spørre Siri absolutt hva du trenger

Så du kan slette Siri-innspillingshistorikken

For et par måneder siden ble Apple tiltalt i en rekke søksmål av forstyrrelse av privatlivet av brukere ved et uhell samlet inn data fra Siri-opptak.

En av saksøkerne hevdet at Apple-ansatte som jobber i divisjonen kunstig intelligens relatert til den virtuelle assistenten fra Siri “Vanligvis lyttet” til konfidensielle detaljer av brukere når de evaluerer disse lydopptakene. Og husk at Siri er tilgjengelig på iOS, iPadOS, watchOS, tvOS, macOS og HomePodOS.

De anklaget Apple for ikke å gjøre det klart for forbrukerne at noen av Siri-opptakene ble samlet inn for evalueringsformål.

Selskapet reagerte snart, ba om unnskyldning og kunngjorde nye personvernstiltak. De har til og med midlertidig suspendert denne praksis og lovet at de ville introdusere et verktøy som lar dem bestemme om de ville dele lydopptakene deres eller ikke. Disse nye tiltakene kommer i form av et nytt konfigurasjonsalternativ som er tilgjengelig i Innstillinger.

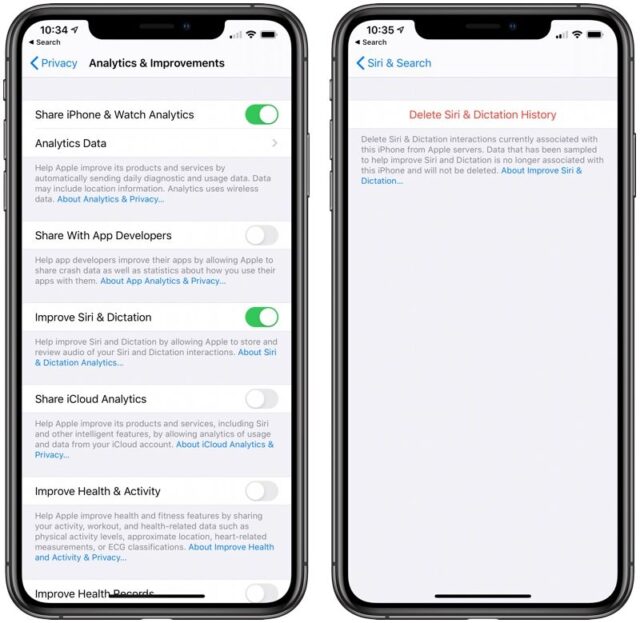

Takket være dette nye alternativet som heter “Slett Siri og dikteringshistorikk” vises i Siri og Søk-kategorien med Innstillinger.

Det er interessant å huske at mens “Diktasjon” Apple refererer til både dikteringen av meldinger gjennom den virtuelle assistenten og dikteringen av tekst gjennom tastaturet.

Du kan se et skjermbilde av hvordan det nye alternativet for å slette Siris innspillings- og diktasjonshistorikk vil se ut nedenfor:

Andre nye iOS 13.2-alternativer

Ankomsten av iOS 13.2 vil innebære utseendet til flere personvernfunksjoner relatert til den virtuelle assistenten fra Siri. Faktisk, i selve iOS 13.2-installasjonen, vil du finne en skjerm der du kan bestemme om du vil at Apple skal samle lydopptakene dine.

Slik forklarer Apple, i full klarhet, hvordan disse lydopptakene brukes:

“Hjelp deg med å forbedre Siri og Dictation ved å la Apple lagre og gjennomgå lyd av dine Siri og Dictation-interaksjoner på denne iPhone og på tilkoblede Apple Watch eller HomePod. Du kan endre dette senere i innstillingene for hver enhet. Disse dataene er ikke tilknyttet din Apple ID, og vil bare bli lagret i en begrenset periode. “

I personverndelen til iOS-innstillingsappen er det også et alternativ til deaktiver “Siri Enhancement and Dictation”. Og til slutt har Apple tatt med en ny finjustering i Siri-delen som gjør at opptak kan fjernes helt.

“Fjern Siri og Dictation-samhandlingene som for øyeblikket er tilknyttet denne iPhone på Apples servere. Data som er samlet for å forbedre Siri og Dictation, vil ikke bli tilknyttet denne iPhone-en igjen og vil ikke bli slettet. “

På den annen side, i tillegg til disse iOS 13.2 personvernalternativene relatert til Siri og Dictation, fra Apple har de også nevnt at de jobber med implementere flere endringer i din menneskelige evalueringsprosess for å minimere datamengden som Apple-ansatte har tilgang til.

Helt sikkert…

Vi forstår at det er vanskelig å fordøye å forestille oss at ansatte konstant ser lydopptakene dine og ber Siri om å slå på stuen, åpne en app eller søke på Google etter data. Sannheten er at teknologiens verden blir til noe veldig farlig, en invasjon av privatliv som sakte blir mer og mer som noe ut av en episode av Black Mirror.